【大纪元2023年11月08日讯】(大纪元记者殷瑞娜编译报导)当YouTube网红加比‧贝尔(Gabi Belle)得知有一张自己的裸照在网络上流传时,她的身体变得冰冷。她从未拍过这张照片,这张照片显示,她赤身裸体地站在田野里。她知道这一定是假的。

26岁的贝尔给一位同事发讯息,请求帮助删除该图片。同事告诉她,网络上散布着她的近100张伪造照片,大部分都存放在以存放人工智能生成的色情内容而闻名的网站上。

贝尔说,这些照片已于7月被撤下,但描绘她性爱场景中的新照片已经浮出水面。

“我感到恶心和被侵犯”,贝尔在接受采访时说,“那些私密部位不应该让全世界看到,因为我没有同意,所以有人伪造了我的照片,真的很奇怪。”

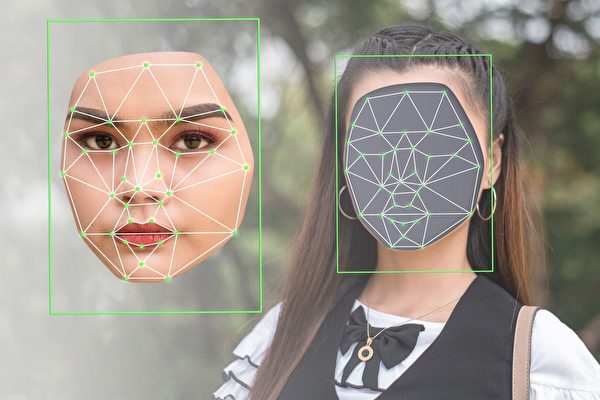

今年,人工智能正在推动虚假色情图片和视频的空前繁荣。

这得益于廉价且易于使用的人工智能工具的兴起,这些工具可以“脱掉”照片中的人的衣服,分析他们赤裸的身体会是什么样子,并呈现在图像中,或者将人脸无缝地替换到色情视频中。

据行业分析师吉纳维夫‧欧(Genevieve Oh)称,自2018年以来,在存放人工智能生成的色情照片的前10个网站上,伪造裸照数量激增了290%以上。

这些网站以名人和政治人物为目标,他们的肖像被不良行为者利用,来羞辱目标人物、勒索金钱或满足私人幻想。

受害者求助无门。目前还没有联邦法律来规范深度伪造的色情内容,只有少数几个州颁布了相关法规。

拜登总统上周一(10月30日)发布了人工智能行政命令建议,但没有要求公司对人工智能生成的照片、视频和音频进行标记,以表明是电脑生成的作品。

同时,法律学者警告说,人工智能伪造的图像,可能不受个人肖像的版权保护,因为它们取自包含数百万张图像的资料集。

旧金山大学法学教授蒂芙尼‧李(Tiffany Li)表示:“这显然是一个非常严重的问题。”

人工智能图片的出现,为女性和青少年带来了特别的风险,他们中的许多人还没有为这种情况做好准备。

监控深度伪造(Deepfake)的公司Sensity AI在2019年的研究发现,96%的深度伪造图片都是色情内容,其中99%的照片是女性。

“现在它主要针对女孩”,宾州大学研究员兼数位权利倡导者索菲‧马多克斯(Sophie Maddocks)说,“那些不在公众视野中的年轻女孩和妇女。”

一名14岁的女孩也在网络上发现了一张自己的裸照。

她从来没有拍过裸照。据警方称,一群当地男孩从他们镇上几名女孩的社交媒体资料中,抓取了穿着衣服的照片,然后使用人工智能“裸体器”应用程序创建了这些裸体照片。

欧检查了排名前10名的伪造色情图片网站,她发现,今年上传的伪造色情图片超过41.5万张,浏览量接近9,000万次。

人工智能生成的色情视频也在网络上爆发。

在搜寻了40个最受欢迎的伪造视频网站后,欧发现,2023年新增视频超过14.3万个,这一数字超过了2016年至2022年所有新视频。欧发现,伪造视频的观看次数超过42亿次。

美国联邦调查局(FBI)6月警告称,诈骗者的性勒索行为有所增加,要求支付费用或照片,以换取不传播色情图片。虽然尚不清楚这些图像中有多少是由人工智能生成的,但这种做法正在扩大。

FBI告诉《华盛顿邮报》,截至9月,已有超过26,800人成为“性勒索”活动的受害者,比2019年增加了149%。

谷歌制订了相关政策,来防止未经同意的色情图片出现在搜寻结果中,但对深度伪造图片的保护措施并不那么强大。

即使没有特别搜寻人工智能生成的内容,深度伪造色情图片以及制作工具也会出现在该公司搜寻引擎的显著位置。

欧在萤幕截图中记录了十多个范例,这些范例均得到了《华盛顿邮报》的独立证实。

在没有联邦法律的情况下,至少有九个州,包括加州、德州和维吉尼亚州,已经通过了针对深度伪造的法案。但这些法律的范围各不相同。

在某些州,受害者可以提出刑事指控,而有些州则只允许提起民事诉讼,尽管很难确定该起诉谁。

科技人权倡导组织“见证者”(Witness)执行董事山姆‧格雷戈里(Sam Gregory)表示,推动对人工智能生成的图像和视频进行监管,通常是为了防止大规模传播,从而解决对选举干扰的担忧。

但格雷戈里补充说,这些规则对深度伪造色情内容没有什么作用,因为在小范围内共享的图片,可能会对一个人的生活造成严重破坏。◇

责任编辑:宋佳怡#