【大纪元2020年05月11日讯】(大纪元记者袁世钢台湾台北报导)人工智慧(AI)可搜集并分析大量的资料,协助人类快速得到想要的答案,但科技部长陈良基表示,由于缺乏推理过程,始终无法获得科学家们真正的信任;资诚联合会计师事务所也指出,AI当前的关卡就是缺乏解释性。不过,台大AI中心已成功让AI对如何辨识人脸作出解释。

陈良基表示,人类总是藉由不断的提问“为什么”以厘清问题、找出答案;而深度学习等类神经网络的AI,可依照自己的规则快速消化大量资料并产出高精准度的答案,但人们发现,AI并无法详细说明推理过程,使人们不敢放心运用AI解决问题,甚至开始质疑。欧盟今年2月发表的“AI白皮书”也提及,缺乏信任是阻碍AI广泛应用的主要原因。

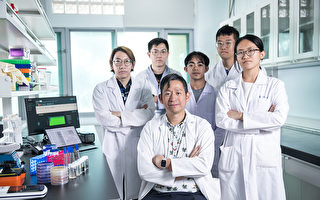

不过,台大AI中心、资讯工程学系教授徐宏民的团队已开发出能嵌合在人脸辨识模型的“可解释性AI(Explainable AI ,XAI)模组xCos”,除了具备高辨识率的人脸辨识能力外,还可有条理的解释产出结果的原因。陈良基说,这项技术不仅可协助国内外相关业者开发AI辨识技术、明白AI决策建议背后的理由,更能提升人类对于使用AI的信任度。

徐宏民表示,他的团队在过去3年中开发人脸辨识产品时,在深度模型设计的过程中会遇到AI人脸辨识结果跟他们的直觉无法吻合的情况,他们对于AI的判断依据相当困惑;为此,团队花了1年多的时间开发出“xCos”,可成功解释辨识的原因,并自动排除人脸不自然的表面,专注在真实、可辨识的位置,进而达到辨识伪装人脸的效果。

科技部长陈良基举例,如果要判断一个人帅不帅,会用身高、眼睛、鼻子、身材等指标来做判断,但AI判定的参数可能达上亿个,AI要如何从上亿个参数当中决定哪个比较重要?这就是科学家们过去一直想要了解的“AI决策黑盒子”,进而判定AI的决策是否能够信赖。

此外,徐宏民说, xCos模组除了可供末端使用者了解人脸辨识结果的成因外,更可协助开发人员检视系统的运作机制,将技术扩展到其他领域的AI决策系统。例如AI仅告知发电厂未来1小时是否要增加发电量,但XAI就可说明是因为预测气候的改变或有特殊节庆等原因;AI可以判断X光片是否有肺炎征兆,但XAI可解释判断的依据、指出病征的位置。◇

责任编辑:郑桦